Ein kleines, entscheidendes Puzzleteil zur optimalen Energienutzung

Gemeinsames Projekt von NAECO Blue und dem KI-Labor der FH Kiel zur Validierung von Wettermodellen

Die effektive Nutzung von erneuerbaren Energiequellen ist ein wichtiger Pfeiler zum Erreichen der Klimaziele. Wechselnde Wetterbedingungen wie Kälte, Regen oder Bewölkung haben allerdings einen direkten Effekt auf die regenerative Energieerzeugung und machen die größten Schwankungen aus. Wie lassen sich diese Schwankungen besser kontrollieren, um genügend Energie im Netz zur Verfügung zu haben und darüber hinaus Energieerzeugern, Händlern und Verbrauchern eine bessere Planbarkeit zu ermöglichen?

Diesen zentralen Fragen widmet sich das Lübecker Start-up NAECO Blue. Das Unternehmen erstellt auf Basis künstlicher Intelligenz Einspeiseprognosen für die Energieerzeugung aus Sonne und Wind und sichert so eine zuverlässige, effiziente und saubere Versorgung durch erneuerbare Energien. Mitentscheidend für genaue Prognosen sind dabei die Daten von Wettermodellen.

„Unser Ziel war die Entwicklung einer Methodik, mit der wir für die verschiedenen Windkraft- und Solar-Anlagen herausfinden, welches Wettermodell die besten Informationen für jeden einzelnen Standort abgibt“, erläutert Felix Ollech, Gründer und CEO von NAECO Blue, „wir wollten konkret wissen: Lohnt es sich, verschiedene kostenpflichtige Wettermodelle zu beziehen? Oder nimmt man eher ein kostenfreies, globales Modell, weil die Vorhersage am Ende doch ganz gut zutrifft?“

An Problemen arbeiten, deren Lösung auch wirklich gebraucht wird

Für diese Herausforderung hat NAECO Blue mit dem KI-Labor der Fachhochschule Kiel zusammengearbeitet. Im Rahmen eines Application-Projekts, das sich an Master-Studierende des Studienganges Data Science richtet, war es die Aufgabe der Studierenden Fabian-Malte Möller und Dustin Werner, die Qualität von zwei unterschiedlichen Wettermodellen zu bestimmen. Betreut wurde das Projekt vom Leiter des KI-Labors Prof. Dr. Michael Prange.

Das Know-how zur Validierung der Wettermodelle haben die Fachleute von NAECO Blue, aber „mir ist es auch aus eigener Erfahrung wichtig, dass die Studierenden den Blick raus aus der Fachhochschule erhalten und mit Unternehmen zusammenarbeiten“, sagt Felix Ollech, „wir hatten intern die Vorrecherche gemacht, aber nicht die Kapazitäten, um verschiedene Validierungen auszuprobieren. Dadurch konnten die Studierenden in der Praxis an Problemen arbeiten, deren Lösung auch wirklich gebraucht wird.“

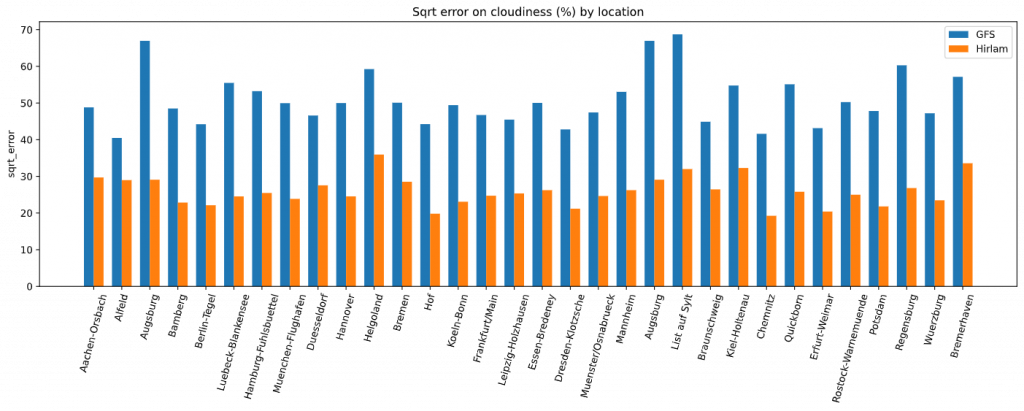

Fabian-Malte Möller und Dustin Werner untersuchten die Modelle GFS und Hirlam und wägten sie gegeneinander ab. Das globale Wettermodell GFS steht auf vielen Webseiten kostenlos zur Verfügung. Es hat eine eher grobe Auflösung von rund 23 mal 23 Kilometern und wird nur circa alle sechs Stunden aktualisiert. Dadurch wirkt es für eine professionelle Nutzung zunächst relativ ungeeignet. Auf der anderen Seite gibt es das kostenintensive regionale Wettermodell Hirlam. Es hat eine feinporigere Auflösung von circa sieben mal sieben Kilometern. Und es aktualisiert sich schneller: Hochleistungsrechner sorgen dafür, dass die Nutzer schon nach etwa einer Stunde einen Forecast haben.

„Von den knapp drei Monaten, in denen die Studierenden bei uns waren, haben sie den ersten Monat hauptsächlich recherchiert und dokumentiert und nur ein wenig programmiert“, erläutert Felix Ollech das Vorgehen, „dies war eine wichtige Grundlage, da Wettermodelle ein sehr komplexes Thema sind. Man muss die Ergebnisse, die man am Ende hat, auch interpretieren können.“

Denn: Der Algorithmus von NAECO Blue für die Einspeiseprognose braucht viele verschiedene Features. „Im Bereich Solar sind es zum Beispiel die Bewölkung, aber auch der Taupunkt, die Temperatur und die Sonneneinstrahlung. Da kommen 40 bis 50 verschiedene Features zusammen. Diese Features haben wir für 60 Standorte in ganz Deutschland untersucht. Und wir haben überprüft, welches der beiden Wettermodelle für den jeweiligen Standort die besten Informationen gibt und haben diese Erkenntnisse historisch validiert.“

Wenige Code-Zeilen mit großer Wirkung#

Vergleich der Modelle Hirlam und GFS

Das Ergebnis: Die Studierenden haben insbesondere durch ihre statistische Herangehensweise Erstaunliches herausgefunden: „Das teure Hirlam-Modell stellt nicht alle Faktoren sehr gut dar“, so Felix Ollech, „sondern ist vielfach schlechter – manchmal sogar deutlich schlechter – als das viel großmaschigere GFS-Modell.“

Fabian-Malte Möller und Dustin Werner entwickelten konkret nur einige Code-Zeilen mit großer Wirkung: NAECO Blue kann nun für einen beliebigen Standort oder eine Liste von Standorten eine Aussage darüber treffen, welche der Wettermodelle in der Historie die besten Ergebnisse für unsere Features bringt. „Dieser Code ist ein kleines, aber sehr entscheidendes Puzzle-Teil zur effektiven Energienutzung.

Die Lösung der Studierenden wird jetzt weiterentwickelt: „Bislang wurden zwei Wettermodelle untersucht. Wir erweitern das auf acht bis zehn Modelle. Und daraus wird eine Automatisierung entstehen, die von allein nach den Informationen aus den Code-Schnipseln sucht.“

Am Ende hat der Kunde eine noch genauere Einspeiseprognose für seine Solar- oder Windkraftanlage. Diese Prognose führt zu großen Ersparnissen, gibt den Akteuren Planungssicherheit zurück und ermöglicht eine effizientere Nutzung der Erneuerbaren Energien.

Weitere Informationen und Ansprechpartner zum Bereich Data Science der FH Kiel finden Sie hier.